La inteligencia artificial (IA) es uno de esos términos que escuchamos constantemente en el mundo moderno, pero puede parecer un concepto abrumador para los principiantes. Sin embargo, ¡no temas! Vamos a desglosar la inteligencia artificial y sus ramas más importantes de una manera sencilla y accesible, para que puedas entender cómo está transformando nuestro mundo.

¿Qué es la Inteligencia Artificial?

La inteligencia artificial es el campo de la informática que se ocupa de crear sistemas capaces de realizar tareas que normalmente requerirían inteligencia humana. Estos sistemas pueden aprender de la experiencia, adaptarse a nuevas entradas y realizar tareas específicas sin la intervención humana directa.

La historia de la inteligencia artificial (IA) es un fascinante relato de innovación, ambición y descubrimiento que se remonta a más de medio siglo. Desde las primeras ideas hasta los avances tecnológicos modernos, la IA ha evolucionado de manera notable, transformando nuestra forma de vivir, trabajar y comunicarnos. En este artículo, exploraremos los hitos más importantes en el desarrollo de la IA y cómo ha llegado a convertirse en una parte integral de nuestra sociedad contemporánea.

Los Inicios de la IA: La Década de 1950

El término “inteligencia artificial” fue acuñado por primera vez en una conferencia en 1956 por John McCarthy y sus colegas en Dartmouth College. Esta conferencia marcó el inicio oficial del campo de la inteligencia artificial, con el objetivo de crear máquinas capaces de realizar tareas que normalmente requerirían inteligencia humana. Durante esta década, los investigadores comenzaron a explorar conceptos como la lógica simbólica y la resolución de problemas, sentando las bases para futuros desarrollos.

Los Años 60 y 70: Primeros Avances y Desafíos

En los años 60 y 70, se produjeron avances significativos en el campo de la IA. Uno de los hitos más destacados fue el desarrollo del programa de ajedrez “El Turco” por parte de IBM en 1950, aunque más tarde se descubrió que era una falsificación. Durante esta época, los investigadores también exploraron el reconocimiento de patrones, el procesamiento de lenguaje natural y la creación de sistemas expertos. Sin embargo, la falta de potencia computacional y la complejidad de los problemas planteados llevaron a una desaceleración en el progreso hacia la IA generalizada.

La Era de la Explosión de Datos y el Aprendizaje Automático

La década de 1980 marcó el comienzo de una nueva era en el desarrollo de la IA con el surgimiento del aprendizaje automático. Los algoritmos de aprendizaje automático, que permiten a las máquinas aprender de los datos y mejorar con el tiempo sin una programación explícita, se convirtieron en un enfoque dominante en el campo. Avances como las redes neuronales artificiales y los algoritmos genéticos permitieron a las máquinas realizar tareas cada vez más complejas, desde el reconocimiento de voz hasta la predicción del comportamiento del mercado.

En el siglo XXI, la inteligencia artificial experimentó un crecimiento exponencial impulsado por avances tecnológicos significativos, como el aumento de la potencia computacional y la disponibilidad de grandes conjuntos de datos. La IA se ha convertido en una parte integral de numerosas industrias, incluidas la atención médica, la automoción, la finanzas y el comercio minorista. Sin embargo, este rápido progreso también ha planteado importantes desafíos éticos y sociales, como la privacidad de los datos, el sesgo algorítmico y el impacto en el empleo.

Inteligencia Artificial vs Machine Learning vs NLP/NLG

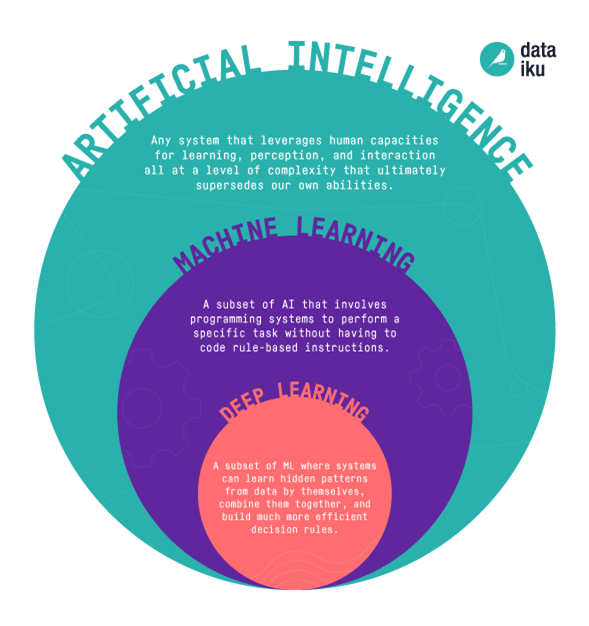

En esta nueva era tecnológica, muchas veces tendemos a mezclar los conceptos de Inteligencia Artificial, Machine Learning (ML) y Deep Learning (DL), pero es importante conocer las diferencias que existen entre estos conceptos para saber cuáles son las técnicas que utilizan y las propiedades que se relacionan con ellos. Es por ello que lo primero que vamos a hacer es aclarar estos conceptos con el siguiente diagrama y su posterior explicación.

Machine Learning: Aprendizaje Automático

El aprendizaje automático es una subcategoría de la inteligencia artificial que se centra en la creación de algoritmos y modelos que permiten a las computadoras aprender y mejorar automáticamente a partir de la experiencia. En lugar de programar explícitamente cada paso, los algoritmos de aprendizaje automático pueden analizar datos y detectar patrones para tomar decisiones informadas.

Procesamiento de Lenguaje Natural (NLP)

El procesamiento de lenguaje natural es una rama de la inteligencia artificial que se centra en permitir que las computadoras comprendan, interpretan y generen lenguaje humano de manera natural. Esto incluye tareas como el análisis de sentimientos, la traducción automática, la generación de resúmenes y la extracción de información de texto.

Natural Language Generation (NLG)

La generación de lenguaje natural es el proceso inverso al procesamiento de lenguaje natural. En lugar de comprender el lenguaje humano, la NLG se enfoca en generar texto coherente y significativo a partir de datos estructurados o instrucciones específicas. Esto se utiliza en aplicaciones como chatbots, informes automáticos y creación de contenido.

Modelos de inteligencia artificial más conocidos

GPT (Generative Pre-trained Transformer)

GPT (Generative Pre-trained Transformer) es una serie de modelos de inteligencia artificial desarrollados por OpenAI. Estos modelos utilizan arquitecturas basadas en transformadores y se entrenan utilizando grandes conjuntos de datos para predecir la siguiente palabra en una secuencia de texto. GPT es conocido por su capacidad para generar texto coherente y realista, y ha sido utilizado en una amplia gama de aplicaciones, desde la generación de contenido hasta la traducción automática y la asistencia virtual.

BERT (Bidirectional Encoder Representations from Transformers)

BERT (Bidirectional Encoder Representations from Transformers) es otro modelo desarrollado por Google que ha tenido un gran impacto en el campo del procesamiento de lenguaje natural. A diferencia de los modelos anteriores que solo miraban las palabras en una dirección (de izquierda a derecha o de derecha a izquierda), BERT utiliza un enfoque bidireccional para capturar mejor el contexto y el significado de las palabras en una oración. Esto ha llevado a mejoras significativas en tareas como la comprensión de preguntas y respuestas, la clasificación de texto y la extracción de información.

Transformer

Transformer es una arquitectura de red neuronal desarrollada por Google que ha demostrado ser altamente efectiva en una variedad de tareas de procesamiento de lenguaje natural. A diferencia de las arquitecturas de redes neuronales recurrentes (RNN) que procesan secuencias de datos de manera secuencial, Transformer utiliza un mecanismo de atención para capturar relaciones entre palabras en una oración de manera más eficiente. Esto ha llevado a mejoras significativas en la velocidad y la precisión del procesamiento de lenguaje natural en una amplia gama de aplicaciones.

GPT-3 (Generative Pre-trained Transformer 3)

GPT-3 es la tercera iteración de la serie GPT desarrollada por OpenAI. Es uno de los modelos de lenguaje más grandes y potentes jamás creados, con 175 mil millones de parámetros. GPT-3 ha demostrado ser capaz de realizar una amplia variedad de tareas de lenguaje natural con una calidad sorprendentemente alta, incluida la generación de texto, la traducción automática, la redacción de código y la resolución de problemas matemáticos. Su capacidad para comprender y generar texto humano como respuesta a una amplia gama de comandos lo ha convertido en uno de los modelos más populares y emocionantes en el campo de la inteligencia artificial.

¿Dónde podemos aplicar inteligencia artificial?

En realidad, la pregunta debería ser al revés, ¿dónde no podemos aplicar inteligencia artificial? y la respuesta sería muy difícil de responder… pero, veamos la primera pregunta. La inteligencia artificial está presente en numerosas áreas de nuestra vida cotidiana, desde los motores de búsqueda que utilizamos hasta las recomendaciones de películas en plataformas de streaming. Algunas aplicaciones prácticas incluyen:

- Asistentes Virtuales: Como Siri, Alexa y Google Assistant, que utilizan NLP para entender y responder a comandos de voz.

- Filtros de Spam: Los algoritmos de aprendizaje automático pueden identificar y filtrar correos no deseados en nuestra bandeja de entrada.

- Reconocimiento Facial: Aplicaciones como Facebook y sistemas de seguridad utilizan algoritmos de aprendizaje automático para reconocer rostros en imágenes y videos.

- Traducción Automática: Plataformas como Google Translate utilizan modelos de aprendizaje automático para traducir texto entre diferentes idiomas. Conclusión

En definitiva, la inteligencia artificial, el aprendizaje automático, el procesamiento de lenguaje natural y la generación de lenguaje natural son solo algunas de las fascinantes áreas que componen este vasto campo. Aunque puede parecer complejo al principio, esperamos que este recorrido haya ayudado a desmitificar estos conceptos y a proporcionar una visión general clara y accesible para aquellos que están comenzando en el mundo de la inteligencia artificial. ¡La IA está cambiando nuestro mundo y tú puedes ser parte de este emocionante viaje hacia el futuro!